東北きりたん歌声DBの制作者さんにアレコレ聞いてみた【インタビュー】

歌声合成界隈に革命を起こしたAIベースの歌声合成ソフト「NEUTRINO」

特に、東北きりたん(CV:茜屋日海夏)のリアルな歌声を合成できることが非常に大きな話題を呼びました

でも、どうして急に東北きりたんの歌唱AIがリリースされたのでしょうか?

というわけで、今回は「東北きりたん歌唱データベース」を制作した明治大学の准教授、森勢将雅先生にお話を伺ってみました。

本日はよろしくお願いします。

早速ですが、森勢先生はNEUTRINOの開発者ですか?

森勢:いいえ。開発者ではありませんが、これがきっかけで新しいソフトウェアの開発が進んだり、オペレーションや調音(調声,調教...etc)の必要性を再認識して頂ければ嬉しいです。

それに関連して、私の方で研究・開発しているエディタはNEUTRINOや関連する技術で作られた歌声を出発点として、調音作業の手間を削減することを目的にしています。

「誰でも同じく,高いクオリティでの歌声合成の実現」ではなく、人間に近い歌声に対し利用者個々人の思い描く個性が自然な形で反映されるエディタを目指しています.

クリプトン社様が新技術を出してきたので,こちらも現在開発中のもの(6月学会発表予定)でひっそり対抗してみるw pic.twitter.com/lPF5BmLkQT

— M. Morise (忍者系研究者) (@m_morise) 2019年3月6日

なるほど。調節が必要ない「完璧な歌声」ではなく、個人が細かい部分をカスタマイズできるコンセプトをベースに開発をなさってるのですね。

ところで、今回の「東北きりたん歌声DB」はどのようにして実現したのですか?

森勢:歌声データベースを構築することは2018年9月時点で決まっておりました。

直接的なきっかけは私のTwitterでの一言です。そこに東北ずん子公式アカウント様からメンションを頂き、具体的に話を進めていくことになりました。

プロの方にお願いできたのは大変ありがたいです.

今回の歌声データベース作成の下敷きには東北ずん子さんの「新しいものには何でも挑んでいく精神」があってこそ、というのもあった訳ですね。

今ふと思ったんだけど,東北ずん子のUTAU音源があるんだったら,統計的歌声合成用の歌唱データセットの収録ってやらせてもらえないかしら.費用はこっち持ちで.

— M. Morise (忍者系研究者) (@m_morise) 2018年10月1日

ずん子はボカロのみなので、イタコ姉さま、きりたん、他のキャラならぜひやって欲しいです♬♬٩(๑❛▽❛๑)۶♡https://t.co/fPWaTca9kz

— 東北ずん子(公式)💚2/13 きりたん誕生日(🔪・ω・)🔪きり!(🗡・ω・)🗡たんー! (@t_zunko) 2018年10月1日

では、歌声データベースについてです。今回の「NEUTRINO」の反響を見ると「きりたっぽくない」「茜屋日海夏さんっぽい」という意見が多いのですが、なぜでしょうか?

森勢:ハッキリとしたことは言えませんが「歌い方」が茜屋様のスタイルだからだと思われます。

歌唱DBの収録では、「きりたんの声真似」で収録をお願いしました。

歌い方については「どういう指示をすべきかが分からなかった」ため、指示していません。ボカロ的に歌う等の依頼は無理だと思います。

なので、声質に注目するときりたんっぽく、歌い方に注目すると茜屋様っぽく聞こえるのではないかと思います。

確かに、声質だけを聞くと「きりたんっぽさ」が部分的に出現していますが、歌い方は声優さんに引っ張られてるから……というのもありそうですね。

(NEUTRINOで出力した東北きりたんのスペクトログラム)

「きりたんの歌声」というよりかは「声優の茜屋日海夏さん」の歌い方を再現した感じになっていますが、声優さんの仕事と競合しないんですか?

森勢:ここは結構悩んだのですが、今回のDBに関しては「東北きりたん」の再現を目指しており、数ある声優の演技の引き出しのうちの1つを肩代わりできるようにしたという判断です。

どちらかと言うと、クリプトンの「キャラクター・ボーカル・シリーズ」と似通ったコンセプトという訳ですね。あちらは「声質と歌い方のデフォルメ」という路線ですが、こちらはキャラクター性を保った上で「きりたんの歌」として十分使えるものを構築したのですね。

(クリプトン・フューチャー・メディアの公式サイトより)

(クリプトン・フューチャー・メディアの公式サイトより)

きりたんの歌声DBをベースに、既存のUTAU音源などから声質データを抽出し、より「きりたんらしい歌声モデル」も作れるのでしょうか?

森勢:理論上は可能だと思います。UTAUで出てきた結果のF0(ピッチ)をNEUTRINOで出力したF0に置き換えることで実現できます。

ただし、どのような音質になるかまではやってみないとわからないです。音素の時間的なズレがあるので劣化しやすく、微調整は必須だと思われます。

ということは、キャラの演技に集中した音声素材を利用して、「キャラの個性を更に際立たせたリアルな合成音声」という表現ができる可能性もあるわけですね。

(AHS公式サイトより)

※歌うVOICEROIDという喋らせるソフトに歌わせるという手法も存在しており、こちらは喋り声のコーパス式データベースを用いて歌わせるので既存の歌声合成よりも「よりキャラらしい」ことになる場合が多い

ところで、UTAUのきりたんは(音質はともかく)超高音も歌わせられるのにAIきりたんではなぜ高音がかすれるのでしょうか?

森勢:これは、合成方法による差です。

UTAUでは元となる歌声の高さを信号処理で調整します。高さの調整に対する破綻が少ない方法を使っていますので品質は落ちにくいです。

一方、NEUTRINOのようなニューラルネットワークベースでは、該当する高さの歌声が存在しない場合の挙動が予測できません。「必ず失敗する」ではなく「予測できない」だけなので、上手に歌える場合もあれば破綻する場合もあります。今回は、それが「かすれてしまう」という形で現れたのだと解釈しています。

なるほど。機械学習がベースになると、人間に「出せる音域」があるのと同じで「使用できる音域を考慮して曲を作る」のも必要になってきますね。

歌わせる音域ですが,A4~D5くらいまではそこそこ歌えると思います.C4~C5くらいはデータ量が安定しています.BPMが140~180がボリュームゾーンでロングトーンは少な目のほうが歌わせやすいです(多分

— M. Morise (忍者系研究者) (@m_morise) 2020年2月22日

音域が狭くなってしまうのは、「東北きりたん」というキャラクターの声質を真似る都合上、声質を維持したまま高域と低域を出しにくいことが原因です。高さの範囲を広げつつ声真似する、というのはかなり難しいと思われます。

キャラらしさといえば、マクネナナのV3も「マクネナナらしさが出るのはC#3~C#4の範囲」ということで得意音域を1オクターブに指定したことで、あちこちでツッコミがあったのを思い出しました。

では、今度は少々マニアックなことをお聞きしますね。

歌声データベース制作に各工程どれくらい時間がかかりましたか?

森勢:収録は5日間に分けて,1回約4時間で実施しました。

収録楽曲は元々i☆Risとしてリリースしたものなので、覚えるための専用の時間は少なく済んだと思います。

MIDIデータの作成は1名が主担当で約1か月、ラベリングはMIDIデータ担当とは異なる1名を主担当としました。

他の仕事もありますので音素ラベリング自体にかかった具体的な時間までは分かりませんが、作業開始から公開まで概ね4か月くらいはかかっています。

だいぶ長期間制作してきたんですね……!

(東北きりたんDB付属の使用曲リスト:計50曲)

50曲収録したとは聞いたのですが、具体的には何分くらいですか?あと、50曲分収録する基準はありますか?

森勢:ラベルデータから計算した音声の存在する区間は約57分です。※readmeでは58分とありますが,こちらは音声分析ソフトで有声区間を算出しているため若干差があります

合成歌唱の品質は傾向としてDBの量に比例しますが、どの程度の量であれば十分であるかは一概に言えません。学習方法等のアルゴリズム、DBの音素・音高の収録バランスに依存するためです。

1つの目安として、NPSS(Neural parametric singing synthesizer)という方法では約31分のデータから高品質な歌声を生成しています。

(NPSSのデモ音声:Sinsyの謡子のデモソングもある)

その他の方法でも独自のデータセットを用意し、限られた楽曲を生成して評価しています。

音源が公開されていないので,妥当な量の計測は簡単ではありません。

むしろ、きりたん歌唱DBが、その妥当性を評価するためのベースラインになり、今後どの程度の量が必要であるかの目安を作れればと思っています。

量が明らかに少ない場合、出現頻度の低い音高や音素等を歌わせた場合分かりやすく破綻します。あらゆる音高・音素等の情報を網羅できていることが1つの目安とは言えそうです。

なお、きりたん歌唱DBでは既存の楽曲をそのまま歌っているので、特に音素の出現バランスはかなり偏っています。

ところで、きりたんの学習曲は著作権の切れていない「i☆Ris」の曲がメインですが、著作権などの権利は大丈夫ですか?

森勢:著作権法が改訂され、新30条の4では「その他の当該著作物に表現された思想又は感情を自ら享受し又は他人に享受させることを目的としない場合」に限り利用できることとなりました。

きりたん歌唱DBに収録された歌を聴くことはアウトですが、学習用として聴かずに利用することは問題ないと解釈しています。

ただし,この改訂は2019年にされたばかりです。前例がないので、上記は我々の見解であることに注意が必要です.

(著作権関連参考記事)

今回はリスクを最小限にするため、キャラクターの利用についてSSS合同会社様と相談し、キャラクター物真似で収録する契約を81プロデュース様と契約しました。

(81プロデュース公式サイトより)

81プロデュースは合成音声の導入に積極的な事務所で、結構前の日経インタビューや「発声権」について話題になっていたところですね。

森勢:声優事務所と契約以外で権利上の問題が生じるとすれば、楽曲制作者側からのクレームです。具体的には管理をJASRACに委託しているでしょうから、JASRACと我々との30条の4の解釈の相違が問題になりかねません。

ここでもめた際のリスク回避として、Facebookによるログインを必須にしました。

森勢:今回の場合は,突き詰めると「インタラクティブ配信にあたるかどうか」だと考えており、JASRAC側の主張が認められた場合は配信料が必要になります。そこで「何名がダウンロードしたか」を管理しておくことで、支払うべき金額を確実に計算できるようにしています。

万が一のトラブルに備えてDL人数を割り出し、穏便な手段で解決できるようにしたのがFaceBookでのログインというわけですね。

データベースの利用に関しては問題ないとして、それを利用した合成結果の利用に関してはどうなりますか?

森勢:データベース制作側が関知するのはデータベースの配布と利用に関するところまでで、DBを利用して作られたソフトウェアが出力した結果については、そのソフトウェアの規約に従って頂くことになります。

ただし、ソフトウェアの利用規約には、常にDBの利用規約が包含するようにして頂いています。そうしないと、収録音声を抜き出して出力するだけのソフトウェアを作ることで、間接的に商用利用ができるようになってしまうからです

ということは、ボーカロイドでも度々話題になる「出力音声で音源作っていいか問題」に対して認可はしつつ、商業利用は禁止というスタンスになりますね。

森勢:また、利用する楽曲によっては著作権の問題が出てきます。

それに関しては、ニコニコ動画やYouTube等の公開先で定められた規約に従う必要があります。

今回のNEURINOに関しては、本体の規約以外に「データベースの利用規約の範囲でご利用ください。」とあるので、同梱されてるSinsy謡子の規約ときりたんの規約に従う感じですね。きりたんの出力音声に関しては商業利用できないんですか?

森勢:はい。こちらはVOICEROIDやリアチェンVoiceと同じで東北企業でも商用利用は不可能です。

では、クリエイターの非商用利用に関してはどうなりますか?(原価回収の同人利用も含む)

森勢:本データベースは研究用に構築したものですので、現状は非商用利用に限定させて頂いております。販売したいという方が増えた場合は何かしら対策を考えたいと思います。

2020年2月26日追記:条件付きで同人利用が可能になりました!

【告知・拡散歓迎】NEUTRINO(AIきりたん)で生成した歌声については,東北ずん子のガイドラインに沿ってご利用頂けることになりました!動画共有サイトへの投稿や同人イベントでのCD販売は,東北ずん子ライセンスでは無償で可能です!

— M. Morise (忍者系研究者) (@m_morise) 2020年2月25日

【告知続き】同人イベント以外でCDなどを販売をする場合,1曲1,000円とキャラクターライセンス料(https://t.co/c328ViB5SS)でのライセンス販売とさせて頂きます.登録用サイトは現在制作中ですので,完成し次第追って報告致します.

— M. Morise (忍者系研究者) (@m_morise) 2020年2月25日

TTS分野での商業利用では、既存のソフト買いきり+商業利用ライセンス有償発行(VOICEROIDなど)以外にも色々路線がありますよね

では最後に。

技術者向けに、今後歌声DBの開発者向けの技術的な情報をまとめて公開される予定はありますか?

森勢:はい、今後そういった情報をWebページなどで公開していく予定です。

何か不明な点がある場合は直接問い合わせしても全然OKです。

質問が増えてきたら、Webにて類似質問と回答をまとめる等いたします。

どういう情報が公開されるのか気になりますね……!

今後の歌声合成の発展や森勢先生開発のエディタなど楽しみにしております。

本日はどうもありがとうございました。

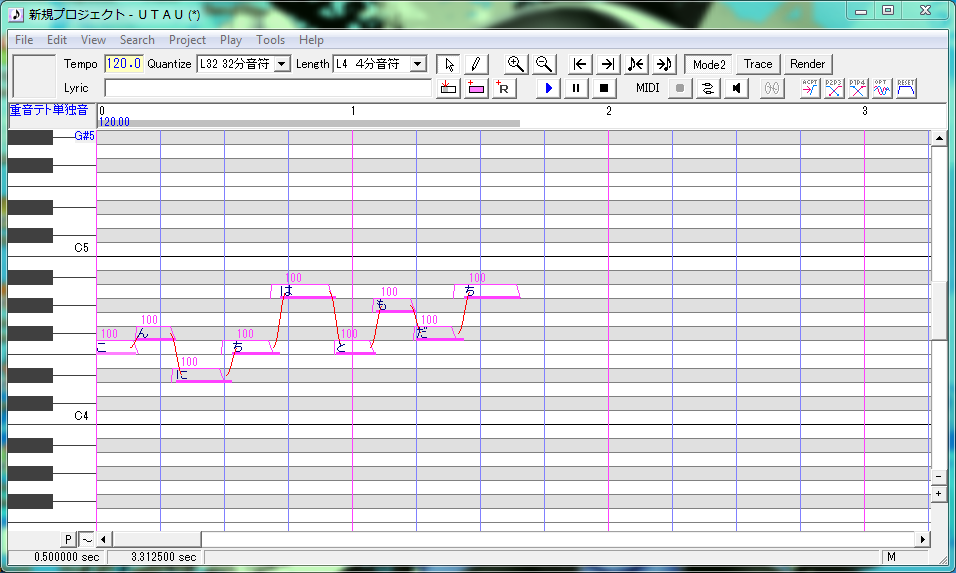

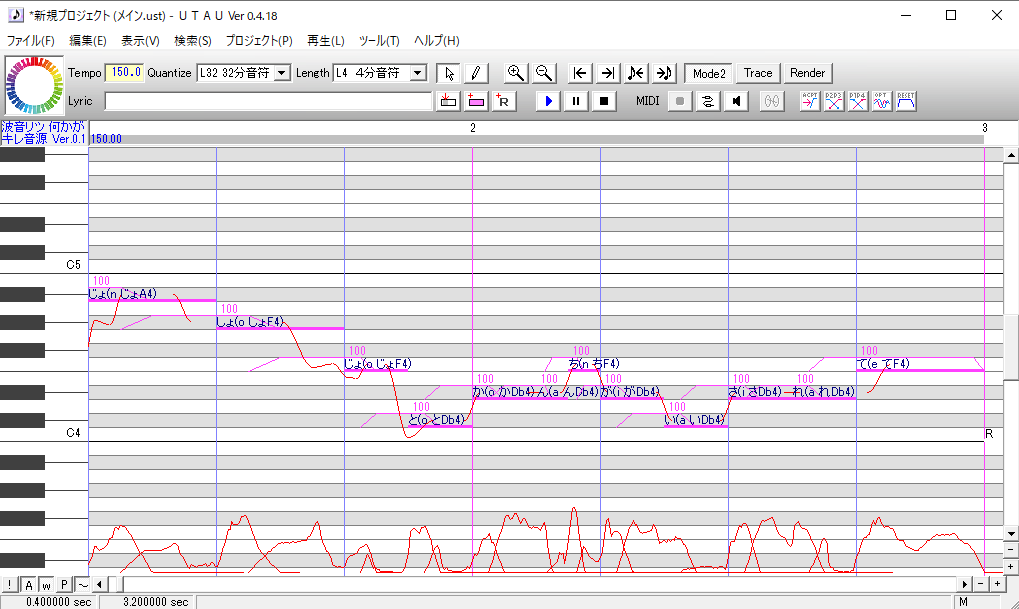

UTAUを経由して手軽にNEUTRINO(AIきりたん)を使う方法

いや~ついに出ましたね、一般ユーザーでも使えるDNN歌声合成ソフト

とはいえ、エディターとか無いのでどうやって簡単に歌声を合成するか解説したいと思います

準備するもの

①何かしら打ち込み済みのデータ(VSQx,UST,CCS,VPR,MIDIなど)

②UTAU

③UtaFormatix

④このUTAUプラグイン

※アップローダーがaxfcなので、場合によってはアンチウィルスソフトなどでブロックされます。別のブラウザを使ったり、一時的にオフにすればダウンロードできる可能性があります

⑤こちらのソフト

やり方

下ごしらえ

①もし、打ち込み済みのデータがUSTではない場合はUTAFormatixを利用してUSTに変換して下さい(MIDIを除く)

もし、歌詞がローマ字の場合は以下のように修正して下さい

②UTAUの「plugins」フォルダに、解凍したSinsy補助プラグインのファイルを入れて下さい

本番

手っ取り早い方法

USTファイルをutau2sinsyにドラッグ・アンド・ドロップしてxmlファイルを作成する

ある程度掛かるけど打ち込みデータの微調整などができる方法

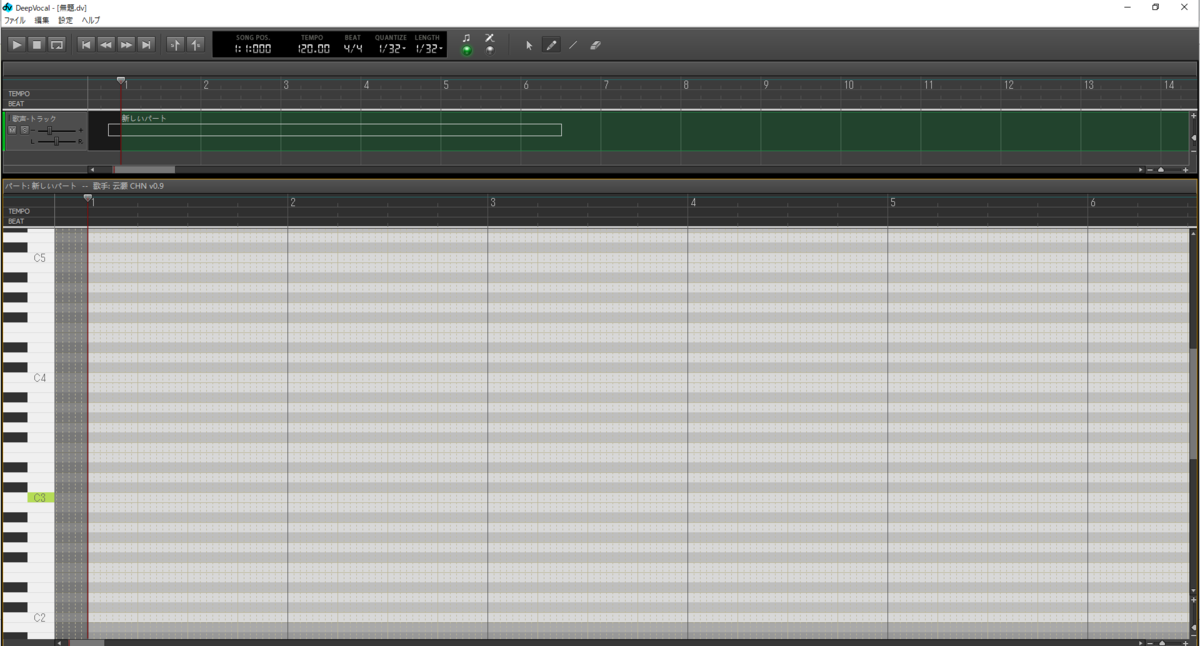

①UTAUにUSTを読み込む

多分こんな感じになります

1※MIDIの場合は左上の「ファイル」→「インポート」から読み込んで下さい

2※その場合、歌詞が入力されていない場合が多いのでツールバーの「Lylic」欄に歌詞を入力し、ノートを範囲選択した後「+R」の2つ左隣のボタンを押して歌詞を入れて下さい

3※歌詞は単独音にして下さい

Ctrl+Aですべてのノートを選択し、「ツール」→「プラグイン」から「HNA_Sinsy補助」をクリックします。

その後、適当な名前で保存します

NEUTRINO側の作業

③XMLを読み込ませる

NEUTRINOの「score」→「musicxml」フォルダに先程出力したXMLファイルをいれます。

この際、先程書き出したxmlの拡張子を「.musicxml」に変更します

④Run.batを書き換える

Run.batをメモ帳などで開いて「set BASENAME=」の先をmusicxmlの名前に書き換えます(拡張子はいらない)

※保存をお忘れなく!

もし、きりたんではなく謡子に歌わせたい場合は13行目の「KIRITAN」を「YOKO」にすればおkです

⑤Run.batを実行する

そしたらNEUTRINOのフォルダを開いて、上のフォルダ名とか書かれてる欄に「cmd」と入力し、エンターキーを押します

そしたらなんか黒い変なのが出てくるので「Run.bat」と入力し、エンターキーを押します

⑥待つ

ちょっと時間かかるのと、結構PCが重くなるので放置しましょう。

そしたらNEUTRINOのoutputってフォルダにいつの間にかレンダリングされた歌声wavが生成されます

【2022/07/05更新】読み上げソフト・サービスをまとめてみた【29+2種類】

注意

読み上げソフトはめっちゃ多いので調べてないものもあります、無いものがあったらコメントでこっそり教えて下さい、こっそり追加します。

一応、利用についてや規約に関しては細心の注意を払っていますが、間違ってる場合もあるので各サービス利用する場合は規約を自分で読み、各自で判断して下さい。

※なにかしらトラブルがあったとしても、この記事を根拠にしないで下さい。

あと、各サービスのデモとしてウェブに体験版が置かれている場合も多いのですが、サービスによっては出力した音声の二次利用を禁止しているので、規約を読んで各自で判断して下さい。

- 注意

- Aquest Talk(ゆっくりボイス,Softalk)

- VOICEROID(ガイノイドTalk・ギャラ子Talk・音街ウナTalk Ex)

- CeVIO/CeVIO AI

- A.I.VOICE

- Megpoid Talk(FineSpeech)

- SHABERU

- 唄詠

- AITalk

- VOICEVOX

- COEIROINK

- コエステーション/コエアバター

- VoicePeak

- Amazon Poly

- Google翻訳

- ボイスソムリエ

- Readspeaker(VoiceText, NeoSpeech)

- CoeFont STUDIO/CLOUD

- TALQu

- Voiceful

- スマホ標準読み上げ機能

- Windows標準 読み上げ機能

- Mac標準の読み上げ機能(VoiceOver)

- Googleクラウド TTS

- Clova Voice

- IBM Watson TTS

- Microsoft Azure TTS

- NTT FutureVoice Crayon

- iSpeech

- N2

- Acapella Group

- おまけ

Aquest Talk(ゆっくりボイス,Softalk)

同人・商用利用:可能(要ライセンス)

株式会社アクエストが開発しているソフト

いわゆる「ゆっくり実況」などで使われる例の声

AquesTalkの音声を利用した読み上げソフトSoftalk

こちらは非営利かつ個人の場合、無償利用が可能。

商用利用する場合は前述のライセンスを購入すること。

VOICEROID(ガイノイドTalk・ギャラ子Talk・音街ウナTalk Ex)

エンジンは株式会社エーアイが提供し、それぞれAHS, ガイノイド(よしもと), ヤマハ、インターネットが販売しているソフト

VOICEROIDには結月ゆかり、琴葉葵・茜、ガイノイドTalkには鳴花ヒメ・ミコト、VFlower(開発予定)、ギャラ子Talkにはギャラ子などのキャラクターがいる

商用利用:

VOICEROIDは要ライセンス(詳細はこちら)

ガイノイドは吉本興業に要問い合わせ(連絡先:contact@gynoid.co.jp)

音街ウナはインターネットに要問い合わせ。(問い合わせ窓口)

※1 東北きりたん, 東北イタコ, ついなちゃんは「商業利用目的でのキャラの吹き替え」はできません。あるいはキャラクターが出ないナレーションのみ可能です。

※2同人利用の範囲なら別キャラの声あてはOKです

※3東北ずん子はいかなる理由であっても商用利用はできません

同人利用:

VOICEROIDは商用ライセンスの要否に準じて可能

ガイノイドはガイノイドTalk利用規約に準じる

ギャラ子は(おそらく)「ギャラ子」名称およびイメージイラスト利用規約に準じる

音街ウナは音街ウナTalk Ex エンドユーザー使用許諾に準じる

CeVIO/CeVIO AI

株式会社テクノスピーチがエンジンを、ブイシンクがエディタを開発。

CeVIO Projectからさとうささら、すずきつづみ、タカハシ

/1st Place社からはIA, ONEが開発・発売されてる。

AHSからはCeVIO AI小春六花、弦巻マキ日本語・英語

1st Place社からはIA, ONEのアップデート版開発・発売されてる。

CeVIO AI ONE TALK -ARIA ON THE PLANETES-【ベクターPCショップ】

CeVIO AI IA TALK -ARIA ON THE PLANETES-【ベクターPCショップ】

商用利用:部分的に無許諾および申請で利用可能(詳細はこちらを参照)

同人利用:可能

A.I.VOICE

AITalk5エンジンを利用した株式会社エーアイの自社製品

現在、琴葉茜・葵

伊織弓鶴

結月ゆかり・紲星あかり

レプリボイス:足立レイ

丹下琴絵

などの音源が販売・制作決定されています

商用利用:要ライセンス

同人利用:可能(※こちらを見て個別に判断してください)

※企業の場合、A.I.VOICE Bizにてキャラクターを含めたコラボ契約も可能。

Megpoid Talk(FineSpeech)

インターネットが開発したソフトウェア

GUMIの音声以外にも男声、女声の読み上げも存在。

加えてトークのイントネーションをVSQxで出力できる機能もある(が精度はやや難あり)

商用・同人利用:可能

※1 法人・法人格・公的機関による利用の場合、非営利であっても利用料の支払いが必要

※2 社内利用の場合は利用料不要

ちなみにエンジンにはAnimoと呼ばれる会社が作ったFineSpeechを採用している

SHABERU

アキヒロ (@akihiro01051)氏の制作したOpen JTalkベースのソフト。

イントネーションなどの微調整は不可能だが、音響モデルの自作(音声データベース)が可能。

↓公式サイト

商用利用:ソフトウェア自体の商業利用は不可能。(詳細は本体付属のReadme参照)

唄詠

SHINTA(@shinta0806)氏の制作した、UTAU音源をゆっくり式に使用できるソフト。

商用利用:ライセンスにより不可だが、営利目的で使用したい場合は作者に事前相談をすることで対応可能な場合アリ。

それ以外の制約:各UTAU音源(キャラクター)の利用規約に準ずる。

AITalk

株式会社エーアイが開発している音声合成ソフト。いわばVOICEROIDの企業向け製品。

エーアイの公式サイトより引用

個人利用:恐らく不可(要問い合わせ)

※1 高額につき

※2 かんたん!AITalk®3及びAITalk® あなたの声®などを除く

かんたん!AITalk®3では、女声×4, 男声×1,関西弁女声×1, 関西弁男声×1が利用可能。

AITalk® あなたの声®では自分の声でAITalkの音源が制作可能(55万円)

※恐らく販売不可、感情表現に対応してるらしいが詳細不明

余談

・AITalkのいくつかの音源はVOICEROIDでも利用されており、以下の通りになっている

まき→民安ともえ(弦巻マキ)

すみれ→結月ゆかり

れいな→琴葉葵

たいち→水奈瀬コウ

あんず→月読アイ

こうたろう→月読ショウタ

VOICEVOX

ヒホ(@hiho_karuta)氏の制作したAI系読み上げソフト、イントネーション等の微調整が可能なのが特徴。ずんだもんや春日部つむぎ、男声数人が実装されいてる。

商用利用:「VOICEVOX:○○」を記載、明示、アナウンスすれば無料(一部キャラにて例外あり)

音源作成:VOICEVOXキャラクター付き音源企画提出フォーム

(常設)と、VOICEVOX Nemo(キャラクター無し音声、恐らく不定期)がある。

COEIROINK

オープンソースになっているVOICEVOXのUI部分を用いてシロワニさん(@shirowanisan)氏が制作したAI系読み上げソフト。つくよみちゃんなどの女声数名と、男声が1種類(おふとんP)実装。

公式サイトにて公式キャラの立ち絵が生成できたり、具体的な規約があったりかなりユニーク。

商用利用:可能(詳細は各音源の規約を参照)

音源作成:MYCOEIROINKにて自作可能。

コエステーション/コエアバター

東芝が開発したディープラーニングベースのアプリ(一般ユーザー向けではiOS限定)

アプリ版では読み上げた文章を基に学習し、自分と似た声を合成できるようにできる

エディタ版では様々な声から読み上げを製作可能。感情の割合をブレンド可能。

VOCALOIDで歌声ライブラリが制作された「蒼姫ラピス」が発売。

個人利用:コエアバター販売に伴い個人利用も可能(要問い合わせ)

商用利用:要問い合わせ(月額3万)

コエステアプリの同人利用:不可(利用規約の禁止事項[13-23]にて「複製・録音」が禁止されている」)

※コエステアプリで生成した音声を画面録画・録音してYoutube, ニコニコ動画、TwitterなどのSNSサービスや共有サービスにアップロードすることは禁止されています

デジタルボイス・プレミアム

前述のコエステの個人向け有償版

コエステーションエディタに加え、スマホアプリに制作した高品質データを提供。

東芝ホームページより引用

制作費用:50万円

※収録は都内近郊の(エイベックス)収録スタジオで行うらしいので、都内在住でない方は恐らくこれ以外にも交通費・宿泊費が別途必要です。

個人利用:恐らく可能(要問合せ)

商用利用:不明(要問合せ)

VoicePeak

Dreamtonicsが開発したソフトウェア。

現時点で男女各3種類の音源+女児1つの計7種類の声が存在。感情の割合をブレンド可能。

商用利用:可能

Amazon Poly

アマゾンが開発しているディープラーニングベースの読み上げソフト

日本語男女、英語男女、中国語女声、韓国語女声など計8言語使用可能

様々なスピーチスタイルを適応可能、カスタム音源も製作可能。

Amazon Polly のご紹介 | AWS (日本語字幕) (2:08)

商用利用:可能

価格:初年度は無料枠が存在

通常版………月/500万文字無料、超過した場合100万文字/約400円

Wavenet版…月/100万文字無料、超過した場合100万文字/約1,600円

Google翻訳

言わずとも知られたアレ

ページ上には特に利用規約がないので利用に関しては不明です。

余談

昔はGoogleの読み上げは後述のVoiceTextのSayakaが長らく使われていましたが、近年になってGoogle独自の音声合成(後述のGoogleクラウド TTSの低品質版)が使用されるようになった経緯があります

ボイスソムリエ

日立が開発したコーパスベースのソフト

www.hitachi-solutions-create.co.jp

日立の公式サイトより引用

個人利用:恐らく不可

※1 高額につき

※2 学生の場合、大学の生協経由でアカデミック版の購入が可能

商用利用:要ライセンス

同人利用:(購入できることが前提だが)要ライセンス

Readspeaker(VoiceText, NeoSpeech)

HOYAが開発したコーパスベース、ディープラーニング併用のソフト

読み上げのみならず、歌声などの声質変換なども手掛ける

2017年に合併したオランダのReadSpeakerと合併し、2020年に名称を改めるとのこと

個人利用:恐らく不可(要問い合わせ)

商用利用:要問い合わせ

※このサイトのデモンストレーション音声を出力して二次使用するのは禁止されています。過去にもいろいろな理由でこのデモが非公開になったこともあるので注意してお使いください。

余談

CoeFont STUDIO/CLOUD

東工大発のベンチャー企業「yellston」が開発している読み上げサービス

商用利用:可能

単価:1文字当たり0.05~0.5円(100万文字で5~50万円)

月額

Lite:500円~

Business:3万円~

Enterprise:要問合せ

追加料金:10円で1000ポイント(最低金額100円)

カスタムボイスの作成:

ベーシック……500円(収録時間15分)

ミドルレンジ……1000円(収録時間1時間)

ハイエンド……1500円(収録時間2時間)

TALQu

UTAU系&新人AI系VTuberの「Haruqa」によって開発されたAI系読み上げソフト

商用利用:それぞれ音声モデルの規約による

音源制作:可能(※1, ※2)

※1「Haruqaポイント」と呼ばれる「Haruqaに関係する創作」を一定の条件を満たして制作した場合に獲得できるポイントを対価に製作可能。

※2自作でタコトロン2モデルを制作する、Haruqaさんの配布しているColab用ノートブックを利用しての自作も可能

Voiceful

VOCALOIDのMaikaなどを開発したVoctro Labsの読み上げ・歌声合成・声質変換……etcのソフト。ディープラーニングベース。

Voiceful demo - "Make a celebrity talk or sing"

音声合成、歌声合成サービスの提供以外にも、Unityのアプリやゲーム向けに音声合成エンジンを組み込めるVoiceful Charactorsも販売

それ以外にもウェブのデモにて、声質変換、音声合成(発話・歌声)、音声ファイルのピッチ変更・時間伸縮などが可能。

ウェブ版のデモ利用:不明(規約が見当たらないので要問い合わせ?)

個人利用:Voiceful Charactorに関しては可能、それ以外のサービスは不明(要問い合わせ)

商用利用:Voiceful Charactorに関しては可能、その他不明(要問い合わせ)

Voicerful Charactorsのカスタム音源制作:要問い合わせ

スマホ標準読み上げ機能

iPhoneの場合はSiri, Androidの場合はGoogleの読み上げや各社の読み上げアプリが利用可能な場合がある。

利用規約は各機種の契約書、OSの仕様書などを各自読んで下さい

Windows標準 読み上げ機能

いわゆるナレーター機能(棒読みちゃんなどでも利用可能)

商用利用:不明

(こちらのブログ記事が参考になるかも知れませんが各自で判断して下さい)

Mac標準の読み上げ機能(VoiceOver)

商用利用:不可(ソフトウェアライセンス契約によって禁止)

Googleクラウド TTS

ディープラーニング(WaveNet)ベースの読み上げサービス

Google翻訳読み上げの超上位版

180言語・男・女声の読み上げが利用可能

商用利用:可能

個人利用:可能

価格:

通常版………月/500万文字無料、超過した場合100万文字/約400円

Wavenet版…月/100万文字無料、超過した場合100万文字/約1,600円

Clova Voice

韓国のNAVERが開発したディープラーニングベースの読み上げサービス

商用利用……要問い合わせ

同人利用……可(個人コンテンツ制作目的である限り無料で利用可能)

詳細や細かい利用規約はこちらから↓

IBM Watson TTS

商用利用:可能

個人利用:可能

価格:

ライト版(無料アカウント)……月/1万文字

標準版…1000文字ごとに約2円(2.24円)

プレミア版:要問い合わせ

Microsoft Azure TTS

マイクロソフトが開発したディープラーニングベースの読み上げサービス

Microsoft Azure Text to Speech

商用利用:可能

個人利用:可能

カスタマイズ音源:製作可能

価格:やや複雑なので公式サイトを参照

NTT FutureVoice Crayon

NTTが開発したディープラーニングベースの読み上げサービス

個人利用:恐らく不可(要問い合わせ)

iSpeech

iSpeech社が開発したコーパスベースの読み上げサービス

N2

Android限定で読み上げアプリとしても配信されている

商用利用:不可(利用規約による)

同人利用:不可(利用規約による)

Acapella Group

Acapella Groupが開発したディープラーニングベースの読み上げサービス

https://www.acapela-group.com/demos/

利用について:デモが違法、有害、脅迫的、虐待的、嫌がらせ、不法、中傷的、低俗、わいせつ、わいせつ、他人のプライバシーの侵害、憎悪的、人種的、民族的、その他好ましくないコンテンツへの利用は禁止、あとはこちらを読んで各自判断して下さい。

おまけ

MUTA

厦门优他动漫科技有限公司が開発した歌声・発話合成ソフト

現状で、トーク機能に対応してるのは中国語音源(というより中国語音源しか無い)

Alter/Ego(ChipSpeech)

PLOGUEが開発した歌声・発話合成ソフト

スピーチに対応してるのは英語音源のBONESのみ

※BONES自体は日本語歌唱に対応、あとはフランスのVOXWAVE製音源のALYSが対応

感想

VOICEROIDのみならず、企業向けのTTSソフトでも

大手からTTSのベースを提供してもらう

↓

自社製品に組み込む

↓

一般ユーザーから金を取る

みたいなビジネスって結構あるのね……有名でないだけで。

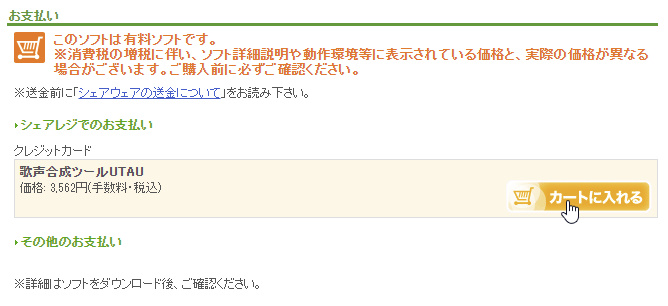

有償版のUTAUで人生が変わった話【買い方もあるよ】

多分タイトルを見た人は

「UTAUって無償じゃないの!?」

「有償版とかあるの????」

「人生変わったとかオーバーすぎるだろ」

って思った人が大半だと思うんですが、実はあるんです!

とはいえ、UTAUはフリーのソフトウェアなのでお金を払う必要はありません、

「新しい機能がほしい!」

「飴屋PさんのUTAU開発支援をサポートしたい!」

「新規エンジン使いやすい!感謝の気持ちを伝えたい!」

と思うのであれば、飴屋さんへのお布施代わりにでもいかがですか?

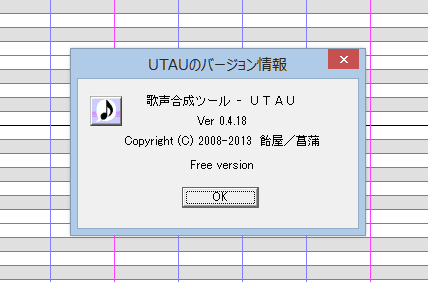

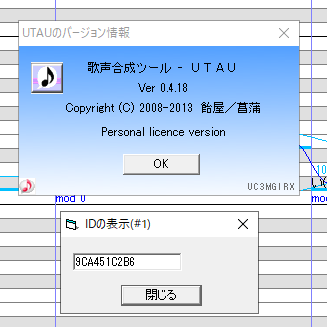

1.有償版とフリー版UTAUの違い

UI面

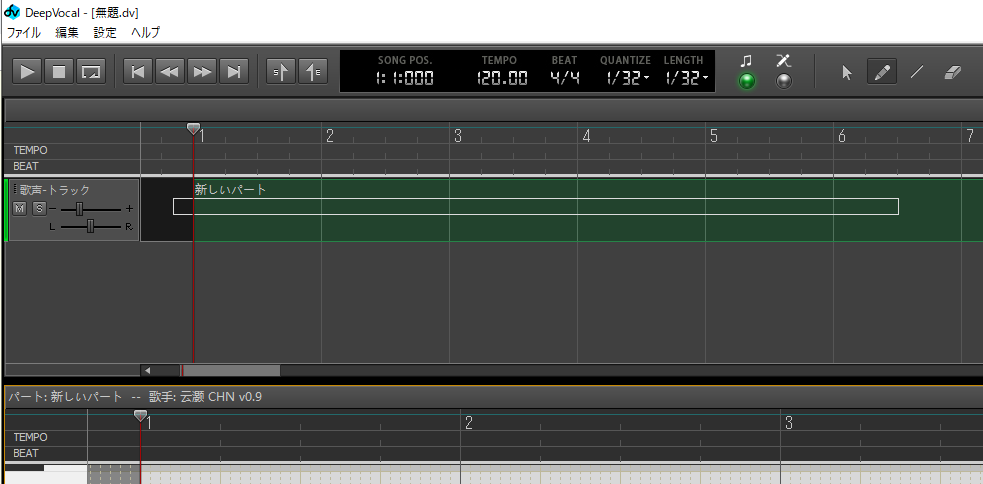

まず、上のツールバーやボタンがあるUIの色が違います

・無償版

(Wikipediaより引用)

・有償版 (灰色のグラデっぽくなってる)

バージョン情報がちょっとカラフルになります

あとなんかユーザーID的なのが出てきます(多分ライセンスコード毎に違うやつ)

・無償版

・有償版

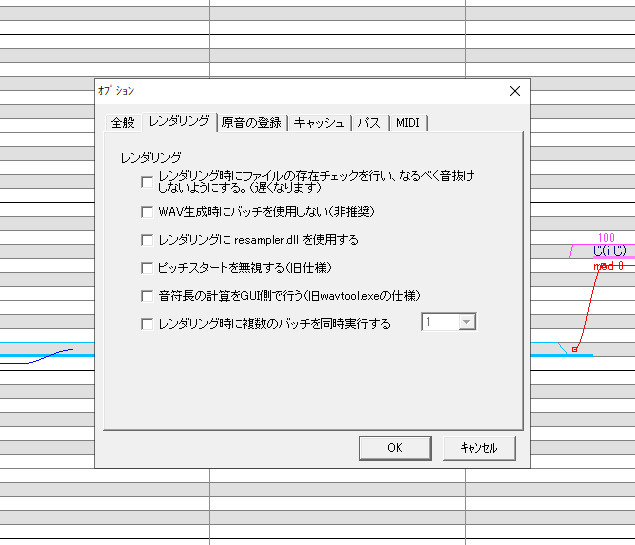

機能面

音声やfrqをレンダリングする際、複数のバッチを同時実行出来るようになります

(多分「resamplerを高速化するツール」的なもの、最大で12まで設定可能)

Mac版のUTAU-Synthで実装されている「自動連続音化」が実装されます

(これ連続音とCVVC併用するとき地味に便利そう)

画面下部に音声波形を表示してくれます(レンダリングが済んだ部分のみ)

それ以外にも「単独音+PrefixMapを優先させる」というボタンもあったんですが………良い使い方がわからないので、このボタンの便利な使い方がわかる方はこっそり教えて下さい

(まだ昔、単独音が主流だった頃[C4/あ]みたいなPrefixがあった時代の名残かもしれません)

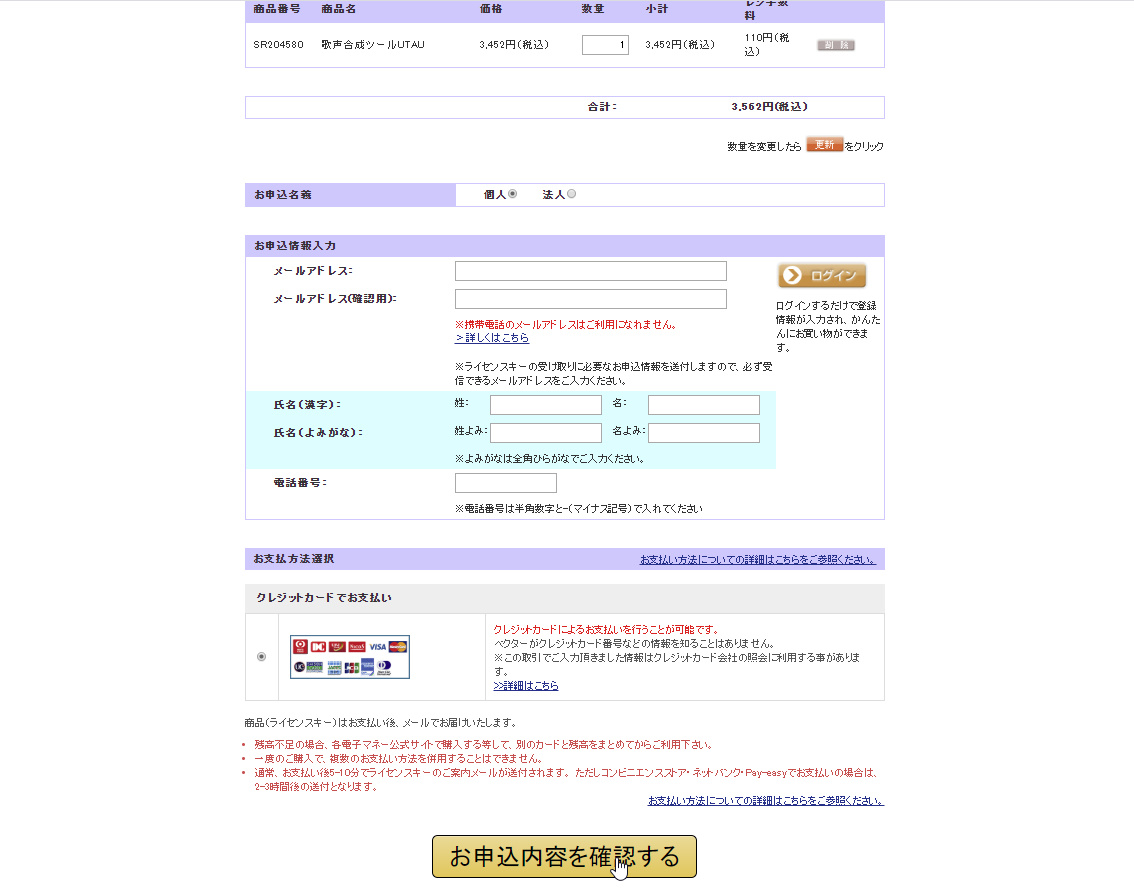

2.有償版の買い方(飴屋さんへのお布施のやり方)

①Vectorに会員登録して、こちらからUTAUをカートに入れます

②必要な情報を入力して確定します

③クレジットカード情報を入力します

クレジットカードが無い場合、VisaデビットやKyashを利用するのがおすすめです!

銀行口座がない場合はKyashを特におすすめします

というのも……

- 手数料無し

- 保護者の同意があれば未成年でも発行できる

- 前払い式の実質デビットカードなので金銭トラブルリスクが低い

- ファミマやローソンなどのコンビニでチャージ可能

- リアルカードを発行すれば実店舗でも使える

類似品のVプリカは手数料がかかりますし、使用する度にブラウザを開かないといけないので、スマホアプリで管理できるKyashは便利だと思います

更に、予めお金を入れておけばPixiv Fanbox、BOOTH、課金などの支払いをする場合にわざわざコンビニまで行く必要がなくなるのですごく楽です!

(Kyashさん案件ください)

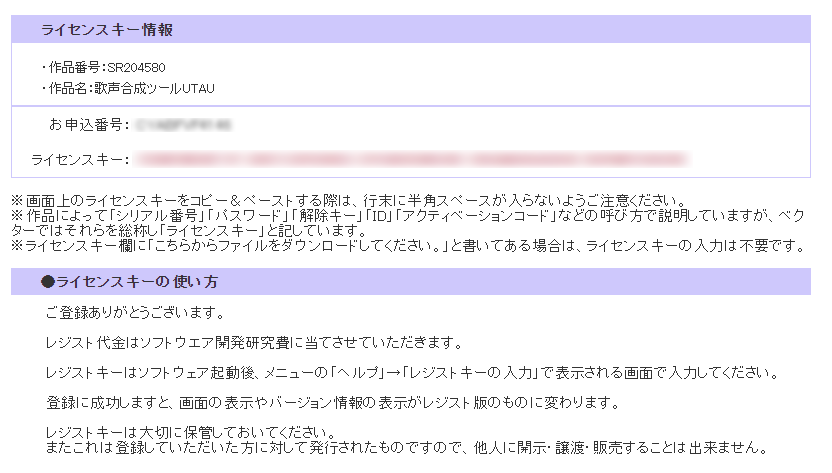

④支払いが終わるとメールが届くので、そこからVectorのページにアクセスしてライセンスキー情報を確認します

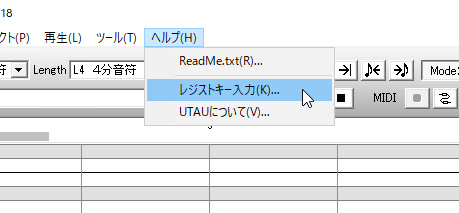

⑤UTAUを開いてライセンスキーを入力します

⑥おめでとう!!!!!

感想

標準エディタでこういうのができるのって思った以上に便利やんけ?

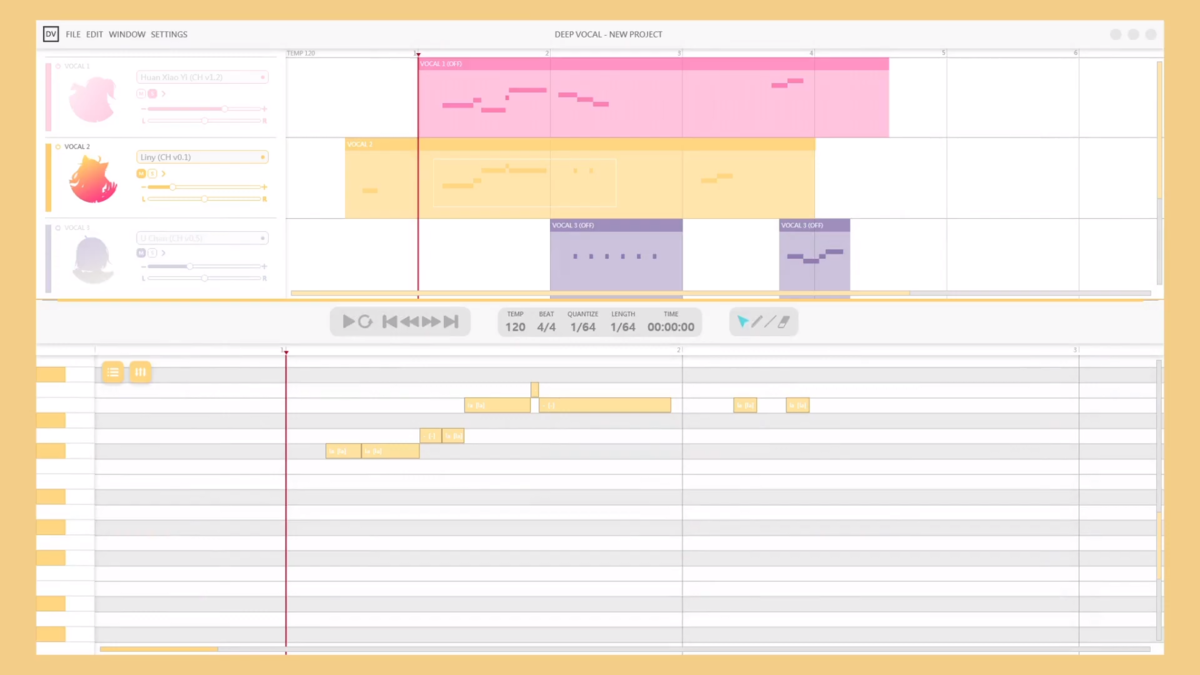

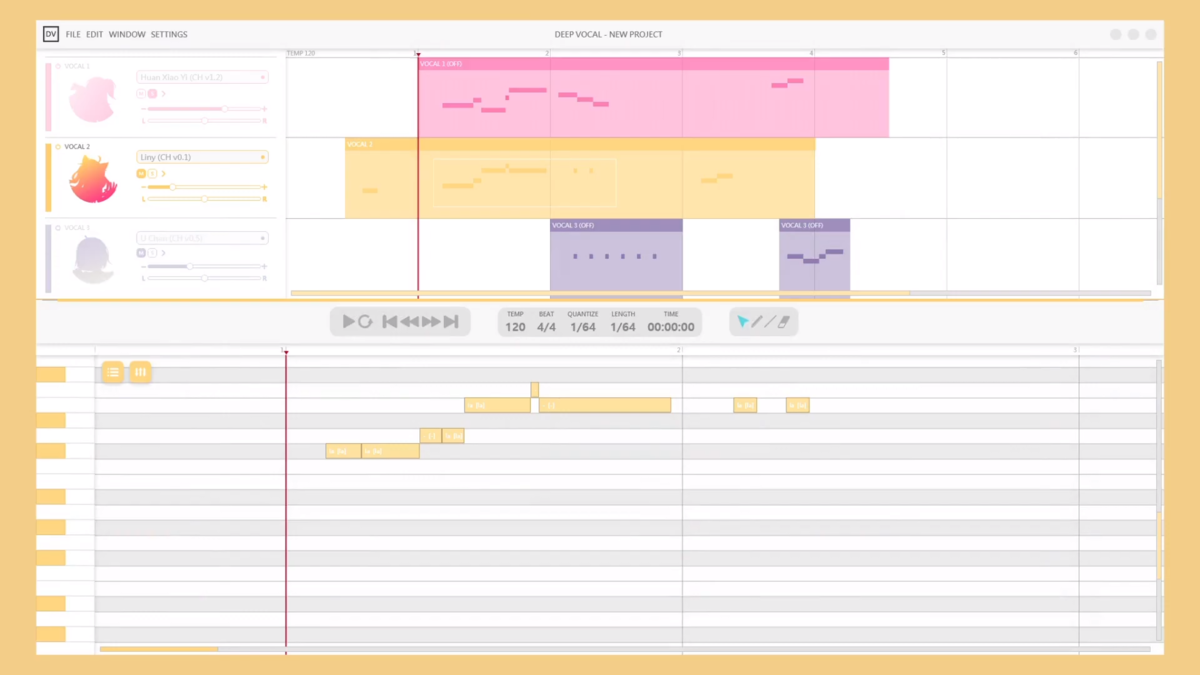

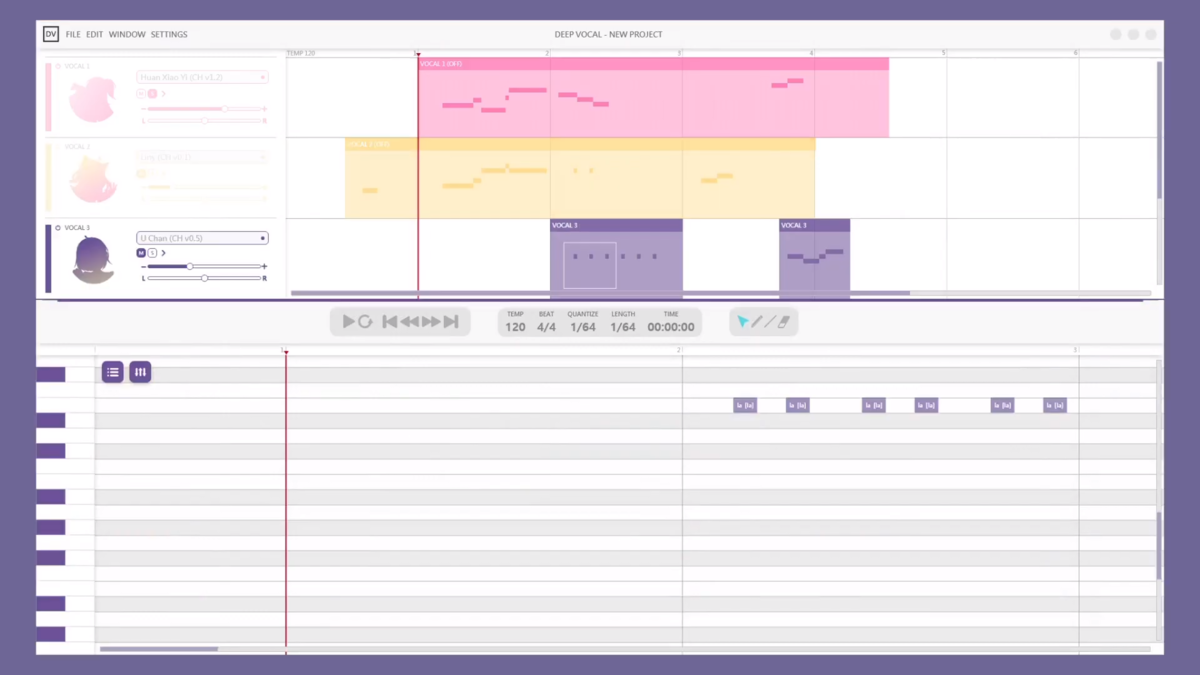

【ネタ記事】非公式で制作されたDeepVocalのUIコンセプト、ガチ過ぎる件について

追記:デザイン系の企業が手の混んだ釣りをやっただけの可能性あるので、この記事はあくまで楽しむ程度にしておいて下さい。

(※この動画が非公式なだけでDeepVocalのUIを本当に担当した可能性はあります)

追記2:「Lain」という個人が制作したあくまでコンセプト主体の動画ということが判明したので本気にしないで下さい(BoxStarさんには既にQQで見せてあるらしいです)

I made a UI concept of DeepVocalhttps://t.co/R8U9t0FuCe#DeepVocal#UIconcept

— Lain Hikaru (CY) (@LainMusic) 2019年11月2日

①謎の団体「MX Design」とは!?

このDeepVocalの動画を出しているのは「DeepVocal」でもなく、「BoxStar」でも無く、「MX Design」という謎の団体です

一体どういう団体なのでしょうか、取り敢えずこのチャンネルには概要欄があるので表示してみることにします。

どうやら、台湾所属のUIなどを制作している企業のようです。

このサイトの概要を以下の制作をメインとするデザイン系企業のようです

- デジタルコンテンツ(モーショングラフィックス、アプリ、ウェブサイト、3Dアニメ)

- グラフィック(CI、パッケージ、展示、広告宣伝)

- サイネージ(看板、案内板)

ざっと見た感じで有名な企業からのオファーも結構ありました

台湾で運営されてる音楽聴き放題サービス「KKBOX」13周年のPV

IKEAの広告用モーショングラフィックス

それ以外にも、リプトンのパッケージデザインを担当した結構のツワモノのようです

DeepVocalの動画をYoutubeにアップロードしたということは、デザインやアプリの一部をこちらの企業に委託したか、あるいは完全委託したというのが妥当な感じがします。

あくまで釣りなので、この企業が携わってるわけではないです。

(※先述のLain氏が勤めてる会社って可能性はあります)

②UI大幅改善!どこが変わったの?

変更点その1

まず、見た目が違います

誰だお前

変更点その2

今のDVは再生ボタンやツール系統が上部に固定されています

コンセプトUIでは、シンガーを編集するスペースの上部に各種ボタンが付随してます、これは使いやすそう……だったのに……。

変更点その3

エディター自体の色んな場所にアンチエイリアスが掛かるようになってます

変更点その4

ミュート、ソロボタン、パン、音量などは前々からあったのですが、見た目が大幅に変わり、キャラクターのアイコンが表示されています

あと、シンガーの名前が表示されてるのでここから音源を選択出来る……と良かったんですけどね……。

変更点その5

デモを見る限りでは、パートを選択した時点でUIの色が切り替わっていたので、「音源ごとにテーマカラーを設定できる」とかあれは最高にアツかったです

変更点その5

基本UIが明るくなった分、ダークモードが実装されるといいな……って感じでしょうか

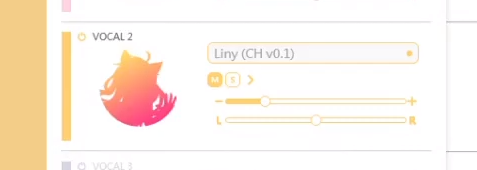

③ここに来てまさかの新音源!?

デモを見る限りではおなじみの「幻晓伊(Huan Xiao Yi)」以外にも「U Chan」と「Liny」の2音源があるのが確認されます

シルエットだけではよく分かりづらいのですが、こちらは恐らくLain Hikaru氏のTwitterアイコンのキャラが元ネタで

こちらはケモミミ要素を持ち合わせた女声音源であることが伺えます。

まだ全体ビジュアルは不明ですが、こちらのTwitterアカウントと関連したプロジェクトではあるようです

もしかしたら、Sharpkey時代に制作した音源だったり、MX Designが新規制作した音源の可能性はあると思います

Sharpky時代.......ケモミミ属性……女声……黄色主体のデザイン……

どこかで見たことあるような気がするんだよなぁ……

結論

コンセプトに関しては壮大な釣り結果的になってしまったけど、DeepVocalの改善は今後発表予定なので色々と楽しみ。

でもこれBoxStarさんのハードルめっちゃ上がったんじゃね?

おまけ

某所からDeepVocalの新規デザインが流出?してるみたいです

いや……これ……Vファイ……やっぱなんでも無いです。

DNN以上の高品質音声合成!?新技術NESを利用したClova Voiceの破壊力!

目次

LINEの親会社、NAVERがこれまた凄い音声合成システムが発表しました

その名も「NES(Natural End-to-End Speech Synthesis)」です!

(日本語に翻訳するなら「端から端まで自然な発話合成」)

取り敢えず、早速どういう感じの音声なのか聞いてみましょう

韓国のNAVERが作った音声合成AI「NES」を使って制作した「クローバーボイス」がヤバイ……

— アマノケイ (@aman0_kei) November 25, 2019

録音データ40分でここまでリアルになるの???

無理やり日本語喋ってもらっても破綻ないし、「喜び」「悲しみ」もある上に個人的なコンテンツ制作における利用なら無料とか強すぎ…https://t.co/R4dk9bVApu pic.twitter.com/NYhjrj8RSM

※Clova Voiceにより出力

どうでしょう!?後半の韓国語は「意味ワカンネ」って感じだとは思いますが、前半の日本語は「韓国語訛りの日本語が波形に破綻なく合成できてる」感じがしませんか?

それだけではなく「普通」「喜び」「悲しみ」といった3つの音色を利用できます!

Clova Voiceの凄いところ

①サンプル時間がものすごく短い!

品質だけを比較するならば、Wavenetや機械学習系の発話合成の方が細かい部分は勝ってるかもしれません(特にClova Voiceは悲しみの息成分が微妙)

ただ、Clova Voiceは「ネイバー独自のspeaker adaptation(話者適応)技法を使用して、約40分レベルの音声録音だけで、高品質の音声合成製作が可能」とのことです。

※話者適応……多人数の収録を基に「平均声」を作成し、目標とする声質に寄せていくタイプの音声合成

そう、40分程度の収録でここまでのクォリティが出せるのです!

②新技術!「NES」

実のところ、NAVERはDNN(深層学習)には昔から手を出しています

例えば、LINEの「クローバースマートスピーカー」などに使われているのは「HDTS(High-quality DNN Text-to-Speech)」というDNNの発展版らしいです。

これは公式サイトによると「特定の分野に必要な声の特性を生かし、最高品質の

合成音を作る技法」と書かれており、恐らく「スマートスピーカー」としての機能が生かせる範囲で重点的な収録を行ったものと思われます。

一方で「NES」は「分野での制約なしに短い録音時間で人に近い自然な声を製作し、提供することができます」とあります。

それ以外にも、「リアルタイムの音声生成が可能なNeural Vocoder」や、Clovaの技術を利用した「感情を反映した音声合成機」などの技術を組み合わせてあの様なリアルな音声を生み出しているようです。

③様々なスタイルの音声が利用可能!

このサイトで一般ユーザーが使えるのは「喜び」「悲しみ」を含めた3種類の声質ですが、それ以外にも

- 「寝る前の読み聞かせに最適な優しい声」

- 「ニュースの読み上げに最適な硬い声」

- 「砕けた友達の声」

- 「淡白な一般人の声」

などが提供される予定とのことです!(※有償サービス版)

④有償サービス版がめっちゃ安い!

有償版は非ログイン型でのAPIを提供していて、動画ダビング、朗読、音声案内、ニュースサービス...etcでの「高音質の音声が必要な事例全般」での使用を想定しているそうです。

今の所提供が可能なのは韓国語の女性のみ&1回毎200文字が上限ですが、1回/5ウォン(訳0.5円)とめちゃくちゃ安いです!

ちなみに、様々なオプションをつけることも、アプリ毎に1日最大500万回まで呼び出し上限を設けることができるそうです。(500万回以上については別途相談可能)

⑤ウェブでのデモ音声は無料で使用可能!

なんとこの音声、無料で利用できちゃいます!

(韓国語訛りの日本語読み上げ音声の使い道があるかは置いとくとして)

- Clova Voiceの合成音は、個人的なコンテンツ制作の目的に限って無料使用が可能です。企業や団体での使用のためには、アフィリエイト提案申し込みにお問合せください。

- Clova Voiceの合成音の使用時にクレジット(Clova Voice)の明記が求められます。

- Clova Voiceを使用して、違法な内容または反社会的な内容(名誉毀損的内容、わいせつな内容、悪口などの暴力的な内容、性差別的な内容など)の合成音を生成をしてはならず、そのように使用したことが確認された場合、今後の利用に制裁を受けることがあります。

というわけで、ルールを守って楽しく使いましょうね!

Clova Voiceに対するQ&A

①Q:どうしてClova Voiceを作ったの?

A:病院や地下鉄などで色んな音声が使われているがその利用には費用と時間がかかる。

音声合成用のデータを作成するとしても既存技術では40~100時間の収録が必要だったのでそれを減らすための技術を開発したかった

②Q:NESの定義は?

A:Natural End-to-End Speech Synthesisの略。

40分で400の文章を読み上げることで肉声に一番近い音声を生成できます。

この技術で時間と費用を画期的に減らした、音声サービス開発やビジネスの大きな助けになった。

③Q:これからの目標は?

今は400文を読み上げないといけないけど、これから先は100文、最終的に1文で済ませられる音声合成器を作るのが目標。

英語や中国語などの言語拡張も行って行く予定。

あと、短い録音で自分だけの「ボイスフォント」を作れるようになると思う。

今後のビジネスについて

Clova Voiceは今ビジネスパートナーを募集しており、ソリューション、技術購入のお問い合わせや、これを活用した新しいビジネスサービスの提供を待っているとのことです。

今の段階で日本語や英語の音声合成をやってくれるかはわかりませんが、NESを使った音声合成に興味がある企業さんがいたら問い合わせてみるのも悪くないかもしれません。

余談ですが、Clova Voiceの使用例には以下のようなものが挙げられています

- 企業の声:その会社だけの特色のある声で会社紹介、広告、売り場案内など、様々に活用してみてください

- 音声予約サービス:反復的で即時的な顧客対応が必要な場面にて、自然で親切丁寧な音声を活用してみてください

- オーディオコンテンツ:自然な音声で、人間が録音するのよりも簡単にオーディオコンテンツを制作してみて下さい

- 音声チャットボット

- 外国語辞書

- 朗読

- 動画の吹き替え

- ゲームキャラの音声(!?)

- 美術館オーディオガイド

感想

日本語でイケボの男性Clova Voice出ないかなぁ~

DeepVocalに連続音(VCV)形式のUTAU音源を移植してみた

発端

すべてはこの動画より始まりました

DeepVocalに無理やり連続音を導入してみた

— アマノケイ (@aman0_kei) August 17, 2019

mono-pitch VCV test with DeepVocal (in not officially supported way)

UST,原曲:耳ロボP 様

Vo:王縄ムカデ 5音階連続音(G3#のみ)

音源:Calarud 様 pic.twitter.com/mQIM5ORRkw

先日、DeepVocalに無理やりUTAUの連続音音源を移植し、かつ連続音(VCV音素)で歌わせて見ました。

これが案外良い感じに行ったのですが、手動で音源を作るとものすごく労力がかかるので「どうにかツールを使って楽に、かつ既存音源の原音設定を利用できないかな……」と思って、ちていこ様に相談したところ、ツールを作っていただきました。

加えて、開発者様のBoxStar様に試作品をお見せしたところ、唯一の課題であった「音素の繋がりが悪い」点が現在クローズ配布中のアルファ版で直していただいたので実用で来そうな感じがしたのでリリースに漕ぎ着けました。

原理

DeepVocalでは現状CVVC形式しか対応してないので、こんな風にしか接続できません

そこでアマノケイさんは考えました、なんとかして連続音(VCV)を使うことはできないかと。

その結果がこちらです。

はい、結合する位置を前の部分にずらしてみました。

見た目としてはCVVCだけど、実質連続音(VCV音素)にしちゃおう!って感じです。

VVCVの長所・短所

・長所

①日本の大多数の日本語UTAU音源はVCVなので、CVVC音源の移植以上に簡易的な移植が可能になる。(ユーザー拡大の切っ掛けになればいいな……)

②モデル構築の際、「無声音が含まれてます」などのエラーが何故か全く発生しない

③既存ツールでoto.iniをdvcfgに変換した際に発生する1.CP、2.PPなどの位置エラーがほぼ発生しない。

④日本語の「ラ」行など、ごく僅かな時間しか鳴らない子音が綺麗に鳴る。

・短所

①子音の長さを調整できない。

②あくまで裏技なので、母音の繋ぎ方が綺麗にならない可能性がある。

③母音のつなぎ目が綺麗に鳴るのが、現在BoxStarさんがTwitterとDeepVocalフォーラムにてクローズ配布中のDVエディタVer1.1.5&DVTB Ver1.1.4であること。

命名の経緯

連続音(VCV音素)の接続をその前の区間でVV音素を使って行うイメージ

なので「VVCV」という名前をつけました

だってそうした方が呼びやすいしかっこいいじゃん

シンボル(エイリアス)規則と標準VVCV音素

・語頭音素

タイプ:CV

すべての「-CV」音素を実装

・VVCV音素

タイプ:CV

例えば「a しゅ」を表記すると「ashu」になります。

「ashu」の内、「ash」が子音扱い(設定区間は「VC」)、「u」が母音となります。

音素の接続はすべて母音間で行われるので、「ash」などはすべて「有声子音」とみなして、「Voiced consonant」リストに入れます。

・VV音素

タイプ:V_X

これは、語頭音素とVVCV、またはVVCV間音素を滑らかにつなぐための音素

母音が「い」の場合「i_X」になるので、例えば上の「ashu」と繋ぐ場合は「i_ash」という表記になります。

※表記上はVCですが、あくまで仕様に則った上での表記で中身は「VV」です

VVCV音源制作方法

VVCV音源使用方法

未実装要素「連続音のVVCV化」

①「e あ」を「eea,ee,a」と記述(nnはナ行子音と共通なので新規で作る必要なし)

②CVを「eea」中身を「e あ」にする

③直前の母音と結合するための「e_ee」(e)を作成

④直後のVV部分の結合はすでに共通部分を作ってるので問題なし

⑤「ea」を入力すると「eea」を参照するように発音記号辞書で設定する

あとがき

VVCV考案の初期段階でインスピレーションを与えてくれた男声UTAU音源「大縄ムカデ」の製作者、Calarud様。

ある程度アイデアがまとまった段階でツール制作に応じて頂いた、ちていこ様。

VVCV形式での音素接続を考慮してDeepVocal側での調整をして頂いた、BoxStar様。

VVCV音源の試作品デモの際使用した女声音源「梶ゆみる」での公開を快諾して頂いた同音源製作者、みのがしさらん様。

この場をお借り致しまして,お礼申し上げます。